Introducción

A continuación se describirán los algoritmos FIFO - SSF - SCAN - CSCAN -

LOOK y junto a ellos al final abra un enlace de Programas simuladores

de cada uno desarrollado en JAVA por estudiantes de la Institución

Universitaria CESMAG de la ciudad de San Juan de Pasto (Nariño)

Colombia.

Al final del blog también se encontraran los enlaces de descarga de los simuladores de algoritmos fifo, scan, cscan y look desarrollados en C++. También hemos preparado para el mayor aprendizaje de estos algoritmos de planificación de peticiones los programas simuladores en un solo paquete cada uno de ellos en Java pero con un entorno GRÁFICO diferente y mas didáctico para que no se te dificulte aprender su funcionamiento y no tengas escusa para comprender y entender todos sus procesos.

Algoritmos FIFO - SSF - SCAN - CSCAN - LOOK, programas simuladores en JAVA.

Al final del blog también se encontraran los enlaces de descarga de los simuladores de algoritmos fifo, scan, cscan y look desarrollados en C++. También hemos preparado para el mayor aprendizaje de estos algoritmos de planificación de peticiones los programas simuladores en un solo paquete cada uno de ellos en Java pero con un entorno GRÁFICO diferente y mas didáctico para que no se te dificulte aprender su funcionamiento y no tengas escusa para comprender y entender todos sus procesos.

Algoritmos FIFO - SSF - SCAN - CSCAN - LOOK, programas simuladores en JAVA.

- ALGORITMO FIFO (Primero en llegar, primero en salir)

Este algoritmo da servicio a las solicitudes

de acceso a disco de la cola según el orden de llegada. Esta planificación hará

uso de una cola tipo FIFO (First In, First Out – Primero en entrar, primero en

salir).

- ALGORITMO SSF (Shortest Seek First ≅ Primero la búsqueda más cercana)

De todas las peticiones atiende primero

aquella que se encuentra mas cerca de la petición que se está procesando. Es

decir, atiende primero la petición que requiere el menor movimiento de la

cabeza de lectura/escritura desde su posición actual.

Enlace para descarga SSF: http://depositfiles.com/files/suwzemnju

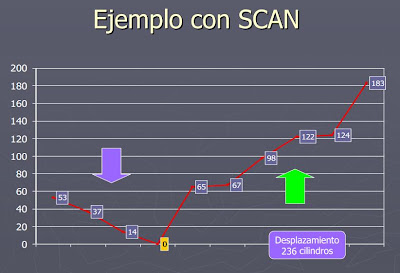

- ALGORITMO SCAN o ALGORITMO DEL ASCENSOR

Este algoritmo recibe el nombre de algoritmo

del ascensor porque se comporta como tal: va atendiendo las solicitudes que va

encontrando en el sentido en el que se van desplazando las cabezas de

lectura/escritura por el disco. Cuando no hay más solicitudes en ese sentido, o

se llega al extremo, se invierte el sentido para hacer lo mismo otra vez pero

yendo hacia el otro lado. Por tanto, en este algoritmo es necesario tener un

bit que indique el sentido del movimiento.

SCAN: las cabezas se mueven de un extremo a otro

del disco, atendiendo las solicitudes que se van encontrando.

Tiempos

de servicio acotados, y más variables en los extremos que en el centro.

Enlace para descarga SCAN: http://depositfiles.com/files/as7zsmmw8

- ALGORITMO C-SCAN

C--SCAN (Circular SCAN): las cabezas se

mueven del primer cilindro al último atendiendo solicitudes, y retornan al

principio.

- Tiempos de espera más uniformes.

- El retorno consume relativamente poco tiempo, porque se hace sin paradas.

- ALGORITMO LOOK

Algoritmo LOOK: las cabezas no se mueven

hasta el extremo, sino hasta la última solicitud pendiente en el sentido del

movimiento.

Fuente de información tomada de:

Algoritmos FIFO, SCAN, CSCAN, LOOK desarrollados en C++ simulando cada algoritmo mencionado, a continuación links de descarga de los simuladores:

Link descarga algoritmo FIFO: http://depositfiles.com/files/5vg4m9bf4

Link descarga algoritmo SCAN: http://depositfiles.com/files/niwvogok3

Link descarga algoritmo CSCAN: http://depositfiles.com/files/56dmxvfig

Link descarga algoritmo LOOK: http://depositfiles.com/files/69yqh1pc4

Algoritmos FIFO - SSF - SCAN - CSCAN - LOOK con entorno GRÁFICO mas didáctico y cómodo para que entiendas de una manera mas fácil el funcionamiento de los algoritmos de planificación de peticiones.

- En esta sección hemos preparado simuladores de cada algoritmo con la gran diferencia que en estos hay un entorno gráfico mejorado donde podrás entender de una mejor manera el funcionamiento de los algoritmos.

Link descarga paquete de algoritmos con entorno gráfico mejorado:

http://depositfiles.com/files/lvl5tbwv1

Los estudiantes de Ingeniería de Sistemas dentro de la materia de Sistemas Operativos junto con la enseñanza del profesor Omar Revelo, hemos querido hacer este aporte a la comunidad de aquellos que estén interesados en este tipo de temas. Esperamos sean de gran ayuda y con ellos aprendan para que en el futuro pasen estos conocimientos a las nuevas generaciones.

fuente: cesmag